安科瑞电气股份有限公司 上海嘉定 201801

摘要:文章分析了位于北京和广州的3个大型数据中心的能耗数据,对数据中心节能存在的问题分别进行了分析诊断。从设计及运行管理两大方面总结了目前数据中心普遍存在的共性问题,为数据中心节能提供了方向。

关键词:数据中心;节能;能效

0引言

近年来随着国家对于信息化工作的重视,作为信息化基础设施的数据中心快速发展。我国数据中心建设的数量多,建设质量也在世界上处于靠前,主要采用了世界上较好的IT设备,较好的制冷设备,较好的精密空调,较好的控制系统。但是衡量运行水平的重要指标PUE却未达到世界先进水平,差距还不小。中国制冷学会于2017年对上海市20家拥有500个机架的数据中心进行了评测,大部分数据中心的PUE分布在1.6-2.3范围内。中位值是1.80,平均值为1.97。距离《“十三五”国家信息化规划》中提出的到2018年大型数据中心年PUE不高于1.5的要求差距较大。

不同的数据中心存在不同的问题,也有其共性的问题,这些问题在业内中已有资料反映。文章结合近期调查的数据中心为例,总结存在于节能运行中的共性问题。

1北京某IDC数据中心

1.1工程简介

该数据中心建筑面积20000㎡,在6B#大楼地下室建有冷冻机房。配置4台离心式冷水机组、4台冷却水泵、4台冷冻水泵,室外地面建有16台冷却塔;机房空调为水冷及风冷两种精密空调系统,空调面积约6000㎡。机房内未设置冷热通道。

为分析数据中心的能效,文章对数据中心的能耗和冷水机组的COP进行了一年的监测记录,并同时对运行管理措施及方法进行了访谈,对冷冻水系统的水温变化进行了全程追踪测试。

1.2能耗分布与PUE

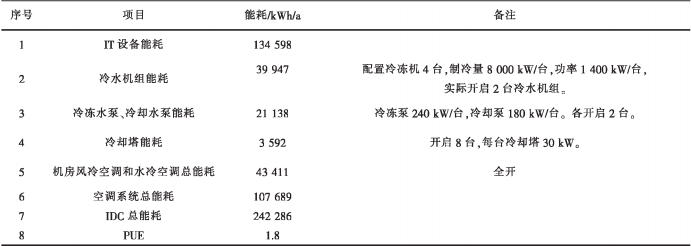

根据约一年的实测数据,该数据中心的能耗分布和PUE见表1,年PUE为1.8。对处于寒冷地区的北京,PUE值偏高。

1.3数据分析

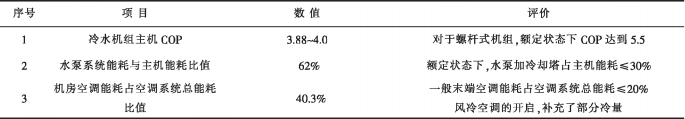

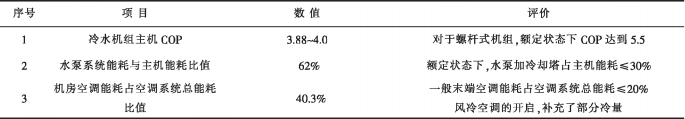

根据能耗分项数据,可以定量计算出空调系统各环节的相对关系,并进行其合理性评价,见表2。

1.4主要存在的问题

根据能耗数据、访谈情况以及水系统状态参数的测试结果,该数据中心的问题主要为:

1)主机效率偏低。主机效率(COP值)小于4.0。2019年7月16日测试期间,冷机冷却水进出口温度3O.3℃/32.6℃,冷冻水出水温度7℃,负载百分比为71%条件下,运行工况与《蒸汽压缩循环冷水机组》(GB/T18430.1—2007)规定的额定条件十分接近。此条件下,主机COP应达到5.5。但主机效率仅为4.0,距离5.5还有不小差距。其原因与冷冻水的水质、机组维护等因素有关。冷却塔填料结垢严重,未及时清洗,使得冷却水温度偏高。

2)水泵的能耗占比过高。设计状态下,水泵的总能耗(含冷却塔)应当只有主机的30%,实际使用中却达到62%。冷水机组的防冻水温差、冷却水温差均只2℃,说明水流量偏大,水泵应可以减少流量。同时测试得到的水泵效率只有50%。

3)分水器与集水器之间存在水量旁通。根据现场测试,末端机房内水冷空调的进出口温度一般为7℃/14℃,温差达到7℃以上。但冷冻站集水器内的温度却为8.8℃。说明分集水之间存在大量的混水,供应到用户的水量不足。

4)机房内精密空调能耗过高。精密空调的能耗比冷水机组能耗还高。一般末端空调能耗应控制在空调系统总能耗≤25%以内,现已大大超出这一比例。按照冷冻机供冷量能力计算,2台冷水机组全部开启时,机房内的风冷空调可以关闭,但机房内所有风冷精密空调仍然全部开启使用。风冷精密空调的使用补充了部分冷量,却消耗了大量的电力。

导致风冷空调开启的原因包括:机房内温度分布不均,有的机房不同地点温差相差10℃,存在局部热点。局部热点的存在,拉低了房间整体温度,加大了供应能力需求。同时由于供应到水冷空调的水量不足,使得水量空调的供冷量不足,因而风冷空调不得不开启。

5)机房内采用漫灌式气流组织,没有设置气流冷热通道。送回风温差小,只有3℃,加大了送风输送能耗。

6)缺少智能化管理手段。虽然有动力环境监测系统,但缺少节能管理的智能化控制系统,也没有统一集中的能耗数据监测系统,使得管理人员对设备运行状况无法细致了解。运维人员的主要精力放在保平安运行上。

7)未利用自然冷源。北京地区冬季自然冷源资源丰富,但未采取任何技术措施加以利用。

表1北京某IDC数据中心能耗数据

表2北京某IDC数据中心分项能耗情况

2广州某云计算数据中心

2.1基本情况

广州某云计算数据中心位于广州市萝岗区。数据中心的空调面积约35000㎡(其中一期15000㎡)。建筑9层,其中数据机房位于3、4层。

数据中心采用集中冷源,冷冻站位于大楼1层,设有4台离心式冷水机组、1台螺杆式冷水机组,配有5台冷却水泵、5台冷冻水泵,5台冷却塔位于5楼屋面。

机房内设有水冷空调机组,通过静压箱送风,共78台精密空调机组。机房内气流分设冷热通道。空调系统日常管理采用手动管理,缺少自动控制平台。除配电房有主要回路的电能监测外,对于能耗监管缺少分项计量,不能进行细化分析。

2.2能耗分布及PUE

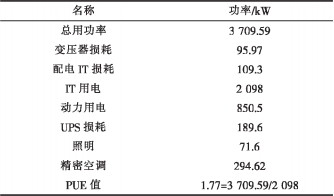

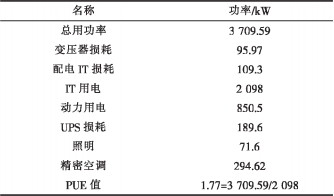

采用瞬时电量进行PUE计算,其值为1.77。数据中心基础设备设施(暖通空调)的功率总和为1099kW,占数据中心总耗电的44%,见表3。

2.3PUE评价

数据中心的电气损耗为466kW,达到数据中心总能耗的13%。变压器损耗6%,UPS损耗12%、列头柜配电系统损耗7%,这部分的损耗较大,应在电气管理和设备配置上改进。

暖通空调系统中冷机电耗占51%、精密空调为26%、水泵+冷塔为21.4%。暖通空调系统内部占比较为合理。但能耗总体比例仍然较高,具有调节改善PUE的空间。

2.4存在的主要问题

1)冷水机组效率未达标。《公共建筑节能设计标准》(GB50189—2015)中4.2.10节要求电机驱动压缩机的蒸气压缩循环冷水(热泵)机组,在额定制冷工况和规定条件下变频离心式冷水机组性能系数(COP)不应低于5.5。而现有机组平均能效系数为5.10,也未达到5.5。在机组运行工况优于额定工况的条件下,仍不满足节能要求。根据访谈介绍,机组每年清洗2次,进行机组水质维护,水质应无问题。应当是机组运行工况不合理造成。

2)冷却水泵的效率低。冷却水泵的效率只有约45%,与设计要求的70%差距较大。冷却水泵的额定扬程30mH₂O,但实际扬程只有15mH₂O。水泵扬程配置过高,偏差较大。冷却塔投入使用时间为2017年,设备状态良好。冷却水出口温度与空气湿球温度差值约为2.3℃。冷却塔效率较高。

3)机房精密空调开启台数过多。机房精密空调能耗占暖通系统能耗30%以上,表明精密空调运行不够合理。现在精密空调全部开启,没有按照回风温度进行控制。

4)缺少智能化管理手段。虽然有动力环境监测系统,但缺少节能管理的智能化控制系统,也没有统一集中的能耗数据监测系统,使得管理人员对设备运行状况无迭细致了解。运维人员的主要精力放在保平安运行上,缺少冷水机组、水泵、冷却塔的节能运行策略。

表3广州某云计算数据中心分项耗电情况

3广州某数据中心

3.1基本情况

该数据中心位于广州市内,分为1#楼和2#楼,于2009年建成使用。均采用集中式冷水机组进行供冷。

1#机楼:该数据中心1层冷冻站设有2台特灵螺杆式冷水机组,配有3台冷却水泵、3台冷冻水泵,屋顶天台设有1台蒸发式冷凝螺杆机、2台冷冻水泵、2组冷却塔;机房均采用上送风、侧回风的气流方式。

2#机楼:该数据中心1层冷冻站由1期及2期合并组成,1期制冷设备为2台约克螺杆机组及配套的3台冷冻水泵、3台冷却水泵、1组冷却水塔;2期制冷设备为2台约克离心式冷水机组及配套的3台冷冻水泵、3台冷却水泵、2组冷却水塔;2#机楼调研的数据机房是2至7层的数据机房;其中4层401/402机房采用上送风、侧回风的气流方式,其它机房均采用地板式机柜送风,上回风加侧回风的气流方式。

整套制冷系统无BA自控系统,所有制冷设备运行模式需人工操作,也缺少能耗计量系统。

3.2能耗分布及PUE

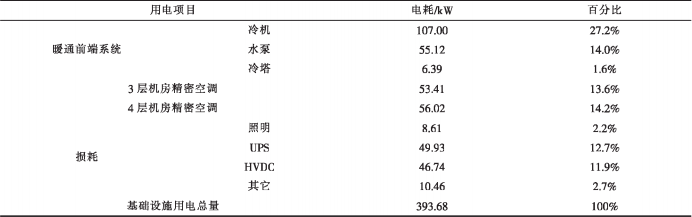

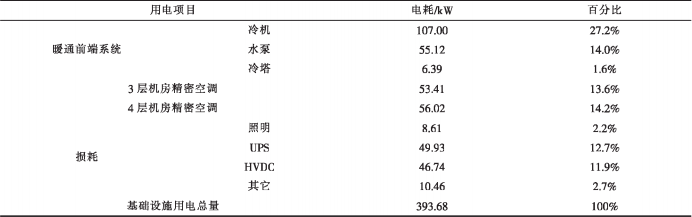

该数据中心的能耗种类均为电力。通过短期测试获得1#机楼和2#机楼的电耗分布。表4、表5给出了1#机楼的具体耗电数据。

3.3PUE评价

1#机楼和2#机楼的短时PUE为1.76-1.86,由于测试在冬季进行,机组处于有利的运行条件,全年PUE值一定高于现有PUE值,说明该数据中心的能效水平较低。

其中UPS和HVDC的负载率低,损耗过大,达到总能耗的约11%。水泵能耗占冷水机组能耗的50%;精密空调的能耗则与冷水机组的能耗相当。说明整个制冷系统效率较低。

3.4存在问题

1)UPS和HVDC的负载率低,造成损耗过大。UPS和HVDC的损耗达到总能耗的约11%。HVDC普遍负荷率平均在35.50%,UPS平均负荷率为24.86%。

应启动高压直流的休眠睡醒功能,根据最低、最高值设定,让HVDC整流模块关闭休眠不必要开启的整流模块,可以大大降低HVDC的损耗。建议在80%~90%启动模块睡醒功能,30%~40%启动模块休眠功能,设置48h休眠模块与运行模块轮换一次。

减低UPS损耗,若UPS的负荷量低于25%时,可以关闭1台UPS,这样就可以降低1台UPS的损耗量。

2)冷却塔冷却效果不佳。冷却塔的逼近度过大,在冬季室外湿球温度13℃时,逼近度达到12.5℃,冷却水塔的填料有损坏以及表面结垢现象较为严重,应更换及定期清洗,可提高冷塔冷却能力。

3)水系统水质较差。水系统维护不及时,导致水质较差,影响冷水机组效率。应定期进行水质的清洗和维护。

4)末端精密空调开启过多。机房内精密空调全部开启,没有根据机房内的实际热量进行送风的调节,送风温差小,送风效率低,送风能耗高。

5)水泵未变频运行。水泵定频运行,供水量偏大,使得输送能耗较高。

6)采用漫灌式气流组织,气流旁通率高,冷空气未送到机柜内部,严重影响送风效率。

7)缺少节能管理手段及运行策略。缺少对室内外环境使用条件、设备状态和运行效果的监测,全靠手工粗放式运行,节能效果差。

表41#机楼总体能耗

表51#楼空调系统能耗分布

4数据中心节能存在的主要问题

通过以上案例及各地其它数据中心的能耗情况,可以看到有些问题普遍存在于目前的数据中心中。

4.1系统设计方面

数据中心设计在产品选型、系统安全性与可靠性设计上都满足了国家节能设计要求和专业设计要求,但设计的精细化程度不够。为了保障安全,选用设备时富裕系数较大,但运行效率偏低。

1)水泵的选型普遍偏大,导致水泵实际工作状态点偏离高效区,水泵运行效率较低。大多数只在50%左右。

2)水管路系统设计粗犷,没有进行细致设计计算,水路流量分配不满足预期要求。有些精密空调的水流量严重不足,水温差达到6℃~8℃以上。

3)一些早年建成的数据中心的冷热通道没有严格分开设计,导致送风气流短路。不仅影响送风效率,也影响了机房空气温度,恶化了运行环境。

4)多数数据中心没有设计自然冷却系统,没有充分利用自然资源。实际上由于数据中心需要全年冷却,在我国大部分地区(除广东、福建等少数地区)都可使用自然冷源。而利用自然冷源是目前降低能耗的有效措施。

5)没有建成能耗分项计量系统。使用者对于能耗的分布不清楚,对能源效率无从知晓。

6)控制系统缺乏有效的调节策略。控制系统智能程度低,仅仅支持泛泛的启停控制等。在控制策略设计时,缺少空调专业的支持。

7)选配的电气设备容量偏大。UPS的使用容量低,导致损耗多。变压器也存在同样问题,使得使用效率低,损耗严重,电气设备损耗占总能耗的10%左右。

4.2运行管理方面

调研结果表明,运行管理方面存在的问题更多,在每一个环节都会出现问题。

运行管理部门始终把数据中心的安全运行摆在第一位,往往强调安全,而忽视了节能,导致许多节能措施不敢使用,这是阻碍节能管理水平提高的重要原因之一。实际运行中应把握好安全与节能的关系。通过了解安全风险因子,了解节能措施的影响程度,可以加深对安全生产和节能技术的科学认识,在安全可控的前提下,加强节能运行管理。

1)设备维护不及时

冷却水系统、冷冻水系统的水质没有严格的质量管理。尽管多数单位有专业的水质维护,但水质的质量管理形同虚设,没有明确的考核检查标准。冷却塔填料结垢十分普遍,也没有及时清洗。

冷水机组的实际运行效率与机组标称值之间相差较大,冷水机组运行效率有待提高。风冷精密空调系统也需要及时维护保养,但许多数据中心缺少对精密空调的专业养护,使得运行效率逐年下降。

2)管路及附件维护不到位,疏于操作

水路上的阀门不管是手动还是自动模式,普遍存在关闭不严现象,导致水流旁通。不仅浪费水泵功耗,还降低了机房精密空调制冷量。温度与压力计量仪表多数不能使用,形同虚设。

台数切换时对应阀门也需进行切换,但由于加大了操作人员的工作量,一般不会落实这项操作。

3)粗放式运行管理

无论是否需要,机房内精密空调全部开启运行,使得精愛空调的能耗与冷水机组能耗相当,大大超出送风系统的能耗标准。

数据中心都设计安装了水系统变频设备,但是实际运行未落实,不能根据水系统温度的变化进行变流量运行。水系统输送能耗约占冷水机组能耗的50%以上,不能随主机负荷随动调节。

冷水机组的启停数量也是完全经验化运行,机组台数的选择缺乏依据,机组不能在高效区运行,使得机组运行效率不高。冷水机组的供水温度没有随着室内负荷变化进行调节,基本全年恒定温度运行。

机房内温度设置偏低。强调运行的安全性后,使机房内回风温度较低,如有的机房要求保持在22℃左右,这样冷水机组出水温度一直压低在7℃,自然冷却的空间也大大压缩。

以上这些因素交织在一起,往往造成数据中心的能耗居高不下。

5安科瑞为数据中心提供的电力监控解决方案

5.1精密配电管理解决方案

AMC系列数据中心精密配电系统是针对数据机房末端设计的,能够综合采集所有能源数据的智能系统,为交直流电源配电柜提供精确的电参量信息,并可通过通讯将数据上传到动环监控系统,实现对整个数据机房的实时监控和有效管理,为实现绿色IDC提供可靠保证。

5.1.1交流系统

1)功能要求:

遥测:输入分路的三相电压、三相电流、有功功率、有功电度;输出分路的单相电压、单相电流、有功功率、有功电度;

遥信:输入分路的过压/欠压,缺相,过流,输入分路和输出分路的开关状态,具备电流、功率需用量分析和统计,实现电压、电流、功率等参数的越限报警功能。

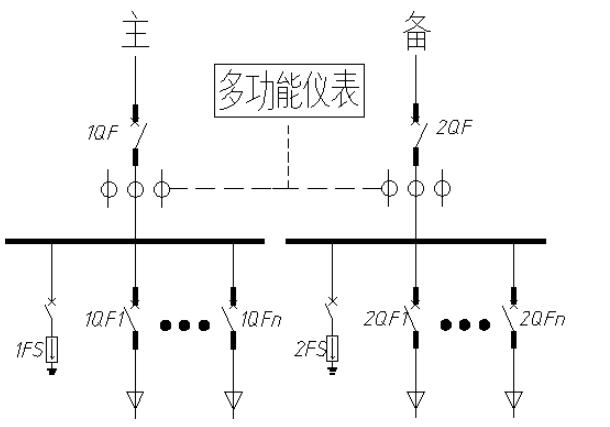

2)配置方案-示意图

配置方案

多功能仪表PZ72L-E4

电流互感器AKH-0.66-30I-XXA/5A

5.1.2直流系统

1)功能要求

遥测:输入分路的电压、电流、功率、电度;

遥信:输入分路的过压/欠压,输入分路的熔丝状态,具备电流、功率需用量分析和统计,实现电压、电流、功率等参数的越限功能。

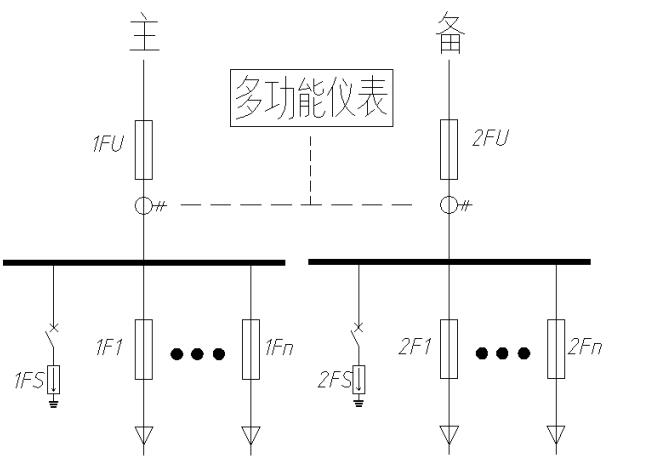

2)配置方案-示意图

配置方案

多功能仪表PZ72L-DE

霍尔传感器AHKC-F-XXA/5V

开关电源SBD-30(48V)

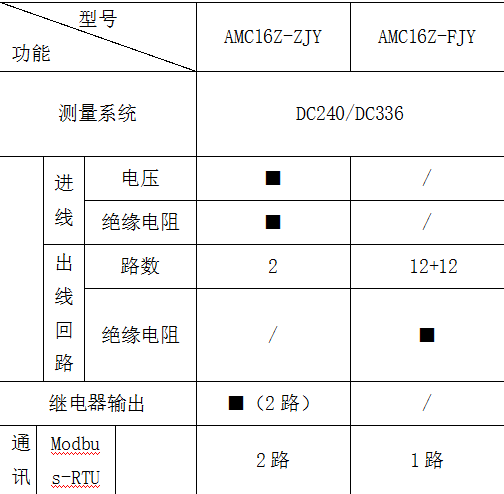

产品规格

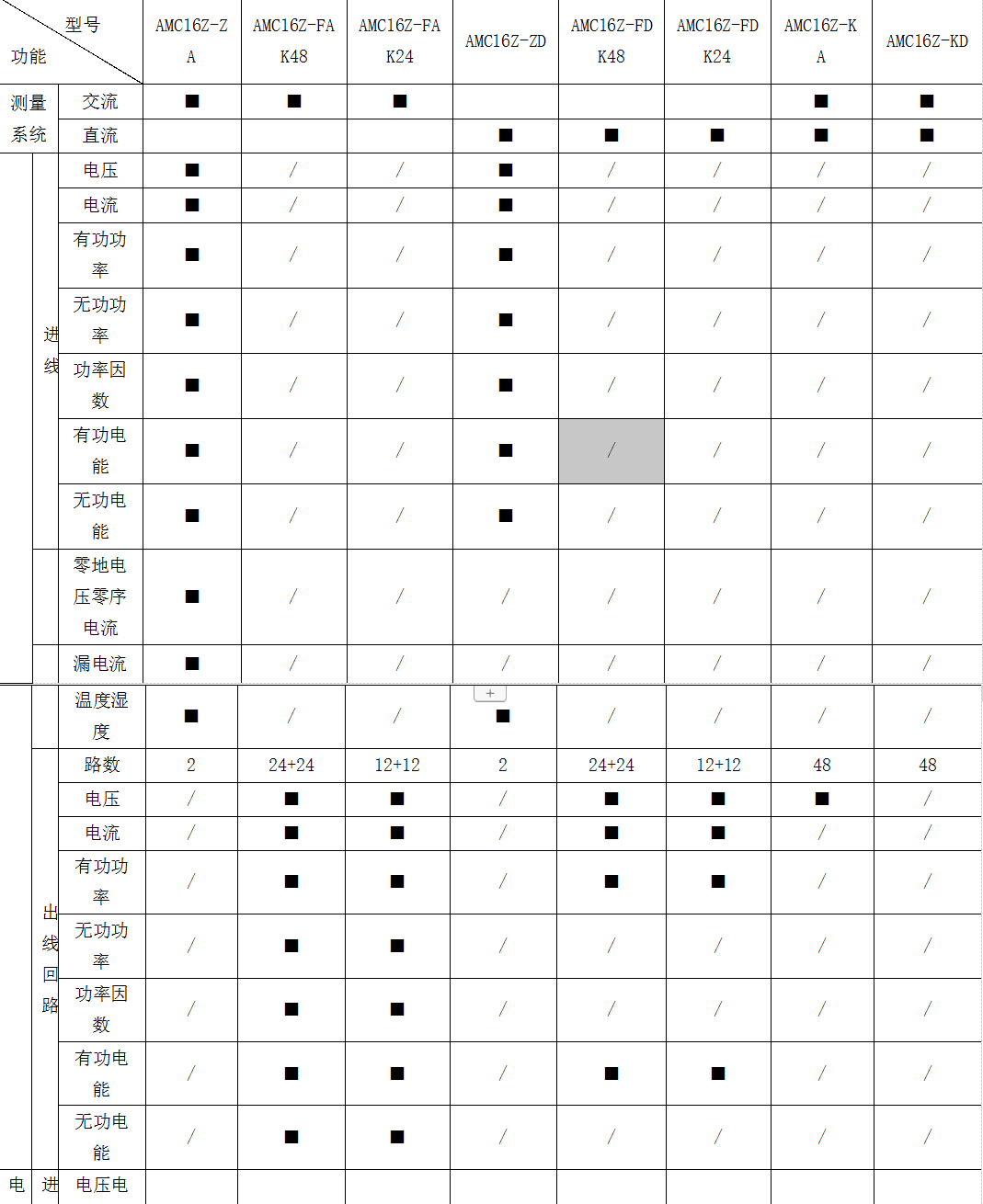

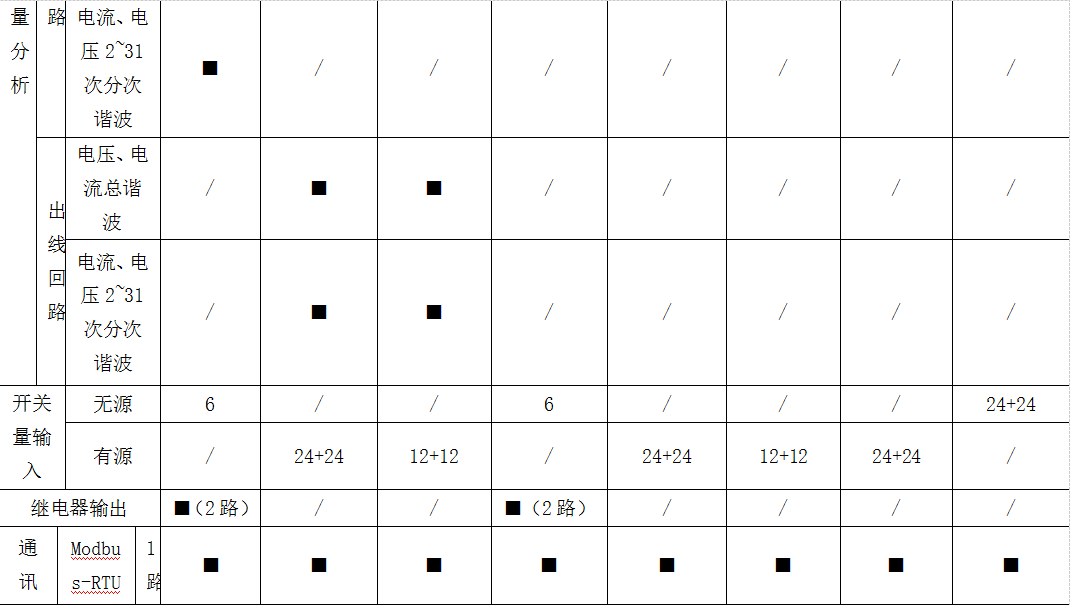

说明:■为标配功能。

配套附件

配套附件

5.2AMB智能小母线管理系统

数据中心小母线系统是数据中心末端母线供配电系统的俗称。近年来,随着数据中心建设的快速发展和更高需求,智能小母线系统逐渐被应用于机房的末端配电中,具有电流小、插接方便、智能化程度高等特点,即插式插接箱给各个机柜内的PDU分配电。始端箱和插接箱内可设置监测模块,将数据上传至动环监控中心。

1)交流系统功能:

遥测:三相电压、电流、有功功率、无功功率、视在功率、功率因数、有功电能、无功电能、电缆温度,系统频率、零序电流、零地电压、漏电流、机柜温度、机柜湿度、开关状态、电压/电流谐波含量、电流/功率;

遥信:过电流2段阀值越限、过/欠压、过功率告警、缺相、过频率、欠频率越限、零地电压、零线电流、温/湿度告警,开关状态、开关跳闸;

2)直流系统功能:

遥测:电压、电流、功率、电能、电缆温度、漏电流、机柜温度、机柜湿度、开关状态、电流/功率;

遥信:过电流2段阀值越限、过/欠压、过功率告警、缺相、温/湿度告警,开关状态、开关跳闸;

产品介绍

说明:■为标配功能。

参考文献:

【1】张晟,李超,梁刚强,顾砒,龚延风.数据中心机房节能运行现状与问题分析

【2】钟聪睿.互联网数据中心(IDC)机房总体规划中的节能设计研究信息通信,2016(8):241-242

【3】卜东洁,王克勇,潘俊等.数据中心机房升溫的研究[J].建筑节能,2015(5):31-33

【4】安科瑞数据中心IDC配电监控解决方案.2020.03版